Описательная статистика

Понятие выборки

Математическая статистика – наука о математических методах, позволяющих по статистическим данным сформулировать выводы о свойствах изучаемого массового явления.

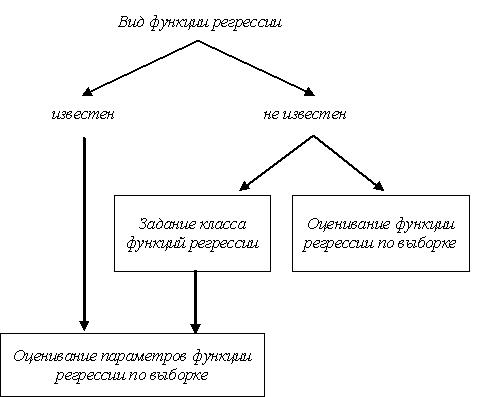

На практике редко доступна полная информация о модели изучаемого явления, описываемого в терминах некоторой случайной величины X. Чаще о законе распределения X имеется лишь частичная информация либо никакой априорной информации о распределении X вообще нет. В этом случае возникают задачи восстановления параметров или вида неизвестного распределения FX или определения его свойств.

Задачи математической статистики являются, в некотором смысле, обратными к задачам теории вероятностей. Если теория вероятностей позволяет при заданной вероятностной модели вычислить вероятности тех или иных случайных событий, то математическая статистика по результатам проводимых наблюдений (по исходам эксперимента) уточняет структуру вероятностной модели изучаемого явления.

Математическая статистика решает следующие задачи:

1) систематизация полученного статистического материала (этап описания массового явления);

2) выявление свойств и закономерностей изучаемого явления (этап анализа и прогноза).

Первой задачей занимается раздел математической статистики, называемый описательной (дескриптивной) статистикой. Описательная статистика предоставляет методы первичной обработки эмпирических данных, их наглядного представления в форме графиков и таблиц, а также их количественного описания посредством основных статистических показателей. Методы описательной статистики, как правило, не требуют предположений о вероятностной природе данных.

Решению второй задачи посвящены теория оценивания и теория проверки статистических гипотез. В основе этих теорий лежат методы построения математических моделей наблюдений и статистических закономерностей.

Точечное оценивание – вычисление приближённых значений характеристик статистических закономерностей по результатам наблюдений.

Интервальное оценивание – построение случайных множеств, называемых доверительными, которые с заданной вероятностью содержат оцениваемые характеристики.

Проверка статистических гипотез – принятие или отклонение по реализации наблюдений априорного предположения о неизвестных характеристиках статистических закономерностей.

С особенностями различных постановок задач оценивания связаны и различия соответствующих статистических исследований.

Центральным понятием математической статистики является выборка. Выборка понимается следующим образом. Пусть случайная величина X наблюдается в эксперименте с комплексом условий G. Результатом этого эксперимента будет некоторое случайное число x – реализация случайной величины X. Повторим эксперимент n раз с неизменным комплексом условий. Результатом такого эксперимента будет случайный вектор (x1,…,xn), где xj – реализация случайной величины X в j-м эксперименте. С другой стороны, вектор (x1,…,xn) можно рассматривать как единственную реализацию случайного вектора (X1,…,Xn), где случайные величины X1,…,Xn независимы в совокупности и каждая из которых имеет тот же закон распределения, что и случайная величина X.

Совокупность всех наблюдений случайной величины X, которые могли бы быть сделаны при данном комплексе условий, называется генеральной совокупностью случайной величины X, или просто генеральной совокупностью X. Распределение случайной величины X называется распределением генеральной совокупности. Число элементов, входящих в генеральную совокупность, называют объёмом генеральной совокупности. Объём генеральной совокупности может быть как конечным, так и бесконечным.

Совокупность независимых случайных величин X1,…,Xn, каждая из которых имеет то же распределение, что и наблюдаемая случайная величина X, называется случайной выборкой из генеральной совокупности X. При этом число n называют объёмом случайной выборки, а случайные величины X1,…,Xn – элементами случайной выборки. Любую реализацию x1,…,xn случайной выборки X1,…,Xn будем называть выборкой из генеральной совокупности X, или выборочной совокупностью. Выборка из генеральной совокупности X представляет собой некоторое подмножество этой генеральной совокупности.

Пример 1. Эксперимент состоит в подбрасывании правильной игральной кости. Случайная величина X – число очков, выпавшее на верхней грани, возможные значения случайной величины X: 1,…,6. В результате эксперимента получаем случайное число x – реализацию случайной величины X, . При повторении эксперимента n раз получаем выборку x1,…,xn наблюдений случайной величины X, , , или, что то же самое, единственное наблюдение случайной выборки X1,…,Xn объёма n. Генеральная совокупность случайной величины X содержит бесконечное число значений 1,…,6 в равных пропорциях.

Пример 2. Исследуется качество партии выпущенных предприятием изделий. Случайная величина X – индикатор брака в изделии – принимает значение 1, если изделие оказалось бракованным, и 0 – в противном случае. В результате наблюдения случайной величины X (выбирая случайным образом изделие) получаем её реализацию x (0 или 1). Обследуя n изделий, получаем выборку наблюдений x1,…,xn, , . Объём генеральной совокупности определяется объёмом партии выпущенных изделий. Объём выборки n не может превышать объём генеральной совокупности.

Понятие выборки может быть обобщено на случай, когда в результате эксперимента с некоторым комплексом условий G наблюдается несколько случайных величин. Например, пусть (x, y) – наблюдение двумерного случайного вектора (X, Y). Тогда случайная выборка объёма n представляет собой последовательность (X1, Y1),…,(Xn, Yn) случайных векторов, а её реализация – последовательность векторов (x1, y1),…,(xn, yn).

Способы представления выборки

Результаты наблюдений x1,…,xn генеральной совокупности X, записанные в порядке их регистрации, обычно труднообозримы и неудобны для дальнейшего анализа. Одной из задач описательной статистики является получение такого представления выборки, которое позволит выявить характерные особенности совокупности исходных данных.

Одним из самых простых преобразований статистических данных является их упорядочивание по величине. Вариационным рядом выборки x1,…,xn называется способ её записи, при котором элементы упорядочиваются по возрастанию, т.е. вариационный ряд выборки – это последовательность чисел

,

удовлетворяющих условию .

Вариационный ряд выборки x1,…,xn можно рассматривать как реализацию вариационного ряда случайной выборки X1,…,Xn. Случайную величину X(i) называют i-й порядковой статистикой (ith order statistic). Число x(i) называют i-м членом вариационного ряда, или реализацией i-й порядковой статистики. Крайние члены X(1) и X (n) вариационного ряда называются экстремальными порядковыми статистиками. Для любой выборки реализации экстремальных порядковых статистик – это её минимальное и максимальное значения.

Можно показать, что функции распределения экстремальных порядковых статистик имеют вид:

|

, |

|

. |

Эти соотношения позволяют оценить неизвестную функцию распределения FX(x) генеральной совокупности X, имея в эксперименте лишь минимальные и максимальные значения выборок.

Разность между максимальным и минимальным элементами выборки x(n) – x(1) называется размахом выборки (range of a sample).

Различные значения случайной величины X называются вариантами.

Пусть выборка x1,…, xn случайной величины X содержит k вариантов z1,…,zk, причём вариант zi встречается ni раз (i = 1,…,k). Число ni называется частотой варианта zi. Очевидно, что сумма частот всех вариантов равна объёму выборки, .

Статистическим рядом называется последовательность пар (zi, ni), i = 1,…,k. Обычно статистический ряд записывается в виде таблицы, первая строка которой содержит варианты zi, а вторая – частоты ni (табл. 1.1), при этом варианты записываются в порядке возрастания.

Таблица 1.1

Статистический ряд выборки

Варианты, zi |

z1 |

... |

zi |

... |

zk |

Частоты, ni |

n1 |

... |

ni |

... |

nk |

В частном случае, если все элементы выборки различны, то k = n, а частоты всех вариантов равны единице.

При большом числе вариантов (например, при наблюдении случайной величины непрерывного типа с высокой точностью измерений) выборка может быть представлена в виде группированного статистического ряда. Для этого отрезок [x(1); x(n)], содержащий все элементы выборки, разбивается на k непересекающихся интервалов J1 = [α0 = x(1); α1), J2 = [α1; α2),…, Jk = [αk-1; αk = x(n)], как правило, одинаковой ширины h. Правые границы всех интервалов, за исключением последнего, задаются открытыми, чтобы исключить попадание граничных точек в соседний интервал.

Число интервалов k выбирают, как правило, в зависимости от объёма выборки. Для ориентировочной оценки числа k можно воспользоваться формулой Стерджесса (Herbert Sturges, 1926):

,

где оператор означает взятие целой части.

Например, при n = 100 оценка числа интервалов по формуле Стерджесса даёт k ≈ 7, при n = 1000: k ≈ 10.

Ширина группировочных интервалов и число групп связаны формулой

|

. |

Более теоретически обоснованный подход к выбору ширины группировочных интервалов дают формула Скотта (David Scott, 1979):

,

и формула Фридмана (David Freedman, 1981):

,

где s – среднеквадратичное отклонение выборки, Δ – интерквартильный размах выборки. Число группировочных интервалов k определяется из (3).

В случае если распределение генеральной совокупности существенно отличается от нормального, число интервалов может быть увеличено. С уменьшением числа интервалов k происходит потеря статистической информации, содержащейся в исходной выборке.

Группированным статистическим рядом называется последовательность пар (Ji, ni), i = 1,…,k. Группированный статистический ряд записывается в виде таблицы, первая строка которой содержит интервалы Ji, а вторая – частоты ni. Иногда в группированном статистическом ряде в первой строке таблицы вместо интервалов J1,…,Jk записывают середины интервалов c1,…,ck, где – середина i-го интервала.

Наряду с частотами ni, i = 1,…,k, попадания выборочных значений в группировочные интервалы рассматриваются также:

– относительные частоты ni / n;

– накопленные (cumulative) частоты ;

– относительные накопленные частоты mi / n.

Полученные результаты сводятся в таблицу, называемую таблицей частот группированной выборки (табл. 1.2).

Таблица 1.2

Таблица частот группированной выборки

Номер интервала, i |

Границы интервала |

Середина интервала, ci |

Частота, ni |

Накопленная частота, mi |

Относительная частота, ni / n |

Накопленная относительная частота, mi / n |

1 |

[α0; α1) |

c1 |

n1 |

m1 |

n1/n |

m1/n |

... |

... |

... |

... |

... |

... |

... |

k |

[αk-1; αk] |

ck |

nk |

mk = n |

nk/n |

mk/n = 1 |

Визуально таблица частот может быть представлена с помощью гистограмм и полигонов частот. Выделяют 4 типа гистограмм (полигонов) частот:

1) гистограмма (полигон) абсолютных частот;

2) гистограмма (полигон) относительных частот;

3) гистограмма (полигон) накопленных частот;

4) гистограмма (полигон) относительных накопленных частот.

Гистограмма частот представляет собой кусочно-постоянную функцию, принимающую постоянные значения внутри интервалов группировки. В зависимости от типа гистограммы это значение может быть абсолютной частотой, относительной частотой, накопленной частотой или относительной накопленной частотой.

Полигоны абсолютных и относительных частот строятся следующим образом: если построена соответствующая гистограмма частот, то ординаты, соответствующие средним точкам интервалов, последовательно соединяются отрезками прямых.

Полигоны накопленных частот и относительных накопленных частот строятся так: если построена соответствующая гистограмма частот, то ординаты, соответствующие правым точкам интервалов, последовательно соединяются отрезками прямых.

Эмпирическая функция распределения. Числовые характеристики выборки

Пусть x1,…,xn – выборка наблюдений случайной величины X, имеющей распределение FX(x). Пусть выборка содержит k вариантов z1,…,zk, причём вариант zi встречается с частотой ni, .

Введём случайную величину дискретного типа , принимающую значения z1,…,zk с вероятностями, равными соответствующим относительным частотам n1/n,…,nk/n, т.е. , . Относительные частоты принадлежат отрезку [0; 1], причём их сумма равна единице, т.е. для относительных частот выполнены все требования, предъявляемые к вероятности распределения. Распределение случайной величины называется распределением выборки x1,…,xn (табл. 1.3).

Таблица 1.3

Распределение выборки

Значения, zi |

z1 |

... |

zi |

... |

zk |

Вероятности, pi |

nj / n |

... |

ni / n |

... |

nk / n |

В связи с тем, что в выборке может присутствовать лишь конечное (или счётное) число вариантов наблюдаемой случайной величины X, распределение случайной величины всегда является дискретным.

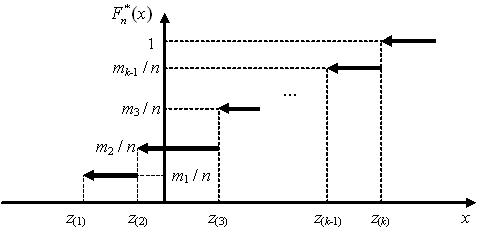

Функция распределения случайной величины называется эмпирической (выборочной) функцией распределения (ЭФР ) и обозначается :

.

Как известно, функция распределения случайной величины дискретного типа представляет собой кусочно-постоянную функцию. График ЭФР для выборки x1,…,xn с вариантами z1,…,zk приведён на рисунке ниже. Несложно показать, что ЭФР может принимать лишь значения, равные накопленным относительным частотам вариантов z1,…,zk либо равняться нулю:

|

|

В точках z1,…,zk ЭФР претерпевает разрыв непрерывности и является, как и любая функция распределения, непрерывной слева.

Поскольку ЭФР выборки x1,…,xn является функцией распределения дискретной случайной величины , то для неё справедливы все свойства функции распределения дискретной случайной величины.

Эмпирическую функцию распределения выборки x1,…,xn можно рассматривать как реализацию случайной эмпирической функции распределения соответствующей случайной выборки X1,…,Xn. При каждой конкретной реализации случайной выборки получаем соответствующую ей реализацию случайной ЭФР.

Выборочными (эмпирическими) числовыми характеристиками называются числовые характеристики случайной величины . К таким характеристикам относятся, например, моменты случайной величины. Напомним, что зная функцию распределения fX(x) случайной величины X (или распределение вероятностей p1,…,pk для случайной величины дискретного типа), математическое ожидание элементарной действительной функции ξ(X) случайной величины X рассчитывается по формулам:

и

для непрерывного и дискретного случаев соответственно.

Учитывая (2), запишем выражение для расчёта выборочного начального момента r-го порядка. Все выборочные числовые характеристики будем обозначать с верхним знаком «звёздочки»:

В связи с тем, что каждый вариант zi встречается в выборке x1,…,xn с соответствующей частотой ni, , каждое произведение может быть записано как сумма ni одинаковых элементов выборки, равных варианту zi. Таким образом, выражение (3) примет вид:

Выражение (3) называется взвешенной формой записи выборочного начального момента r-го порядка, а выражение (4) – невзвешенной.

Взвешенная форма записи выборочного начального момента r-го порядка представляет собой среднее арифметическое различных элементов (вариантов) выборки, возведённых в r-ю степень и взвешенных их частотами. Из невзвешенной формы записи видно, что выборочный начальный момент r-го порядка представляет собой простое среднее арифметическое элементов выборки, возведённых в r-ю степень. В связи с этим нередко выборочный начальный момент r-го порядка обозначается через .

Выборочный начальный момент первого порядка называется выборочным математическим ожиданием и представляет собой простое среднее арифметическое элементов выборки, в связи с чем нередко обозначается через :

Нижний индекс ‘X’ в обозначении выборочного математического ожидания и других выборочных характеристик определяется случайной величиной, наблюдениями которой являются рассматриваемые выборочные значения x1,…,xn.

Операция центрирования выборки состоит в смещении её значений на :

.

Выборочное математическое ожидание (среднее) центрированной выборки ε1,…,εn равно нулю:

.

Учитывая определение центрального момента r-го порядка случайной величины дискретного типа, запишем выражение для расчёта выборочного центрального момента r-го порядка:

Выражение (6) является взвешенной формой записи. Невзвешенная форма получается из взвешенной заменой произведений , , на сумму ni одинаковых слагаемых:

.

Выборочный центральный момент второго порядка называется выборочной дисперсией:

Выборочная дисперсия является мерой рассеяния выборочных значений x1,…,xn относительно их среднего арифметического .

Выборочное среднеквадратичное отклонение (с.к.о.) выборки x1,…,xn определяется как квадратный корень из выборочной дисперсии :

.

Для выборочных начального и центрального моментов применимы все тождества, справедливые для начального и центрального моментов случайной величины дискретного типа. В частности, полезное на практике соотношение между выборочной дисперсией и выборочным начальным моментом второго порядка:

Это равенство следует читать как «выборочная дисперсия равна разности между средним квадратом и квадратом среднего».

Выборочный коэффициент асимметрии (skewness) и выборочный эксцесс (kurtosis) – это коэффициент асимметрии и эксцесс случайной величины :

,

,

Выборочный коэффициент асимметрии характеризует степень асимметрии, а эксцесс – степень «плосковершинности» распределения выборки.

Выборочные характеристики могут быть рассчитаны для группированной выборки. Пусть проведена группировка выборочных данных x1,…,xn на k интервалов [α0; α1), [α1; α2),…, [αk-1; αk]; ni – частота попадания выборочных значений в i-й интервал, – середина i-го интервала, .

При расчёте выборочных характеристик группированной выборки предполагается, что все элементы выборки, попавшие в i-й интервал, находятся в середине интервала. Таким образом, выборочный начальный момент r-го порядка рассчитывается как среднее арифметическое взвешенное середин интервалов, возведённых в r-ю степень, а выборочный центральный момент r-го порядка – как среднее арифметическое взвешенное центрированных середин интервалов, возведённых в r-ю степень. В обоих случаях взвешивание проводится частотами попадания в интервалы:

Выборочной квантилью на уровне вероятности p (или порядка p) выборки x1,…, xn называется квантиль случайной величины на уровне вероятности p. Напомним, квантилью случайной величины X называется точная верхняя граница xp множества значений x, для которых выполнено условие:

.

Для дискретной случайной величины, в частности, для случайной величины , точная верхняя граница этого множества не может быть определена однозначно. В связи с этим для расчёта выборочной квантили на практике используются следующие правила.

1. Значение i-го элемента вариационного ряда x(i) является выборочной квантилью порядка pi = (i – 0,5) / n. Таким образом, соответствие между элементами вариационного ряда и порядком квантилей устанавливается таблицей

Выборочная квантиль, |

x(1) |

... |

x(i) |

... |

x(n) |

Порядок, p |

0,5 / n |

.. |

(i – 0,5) / n |

.. |

(n – 0,5) / n |

2. Для расчёта квантили произвольного порядка p, 0 ≤ p ≤ 1 используется линейная интерполяция значений, приведённых в таблице выше.

Выборочной медианой выборки x1,…, xn называется выборочная квантиль на уровне p = 0,5. Из правил расчёта выборочных квантилей следуют правила расчёта выборочной медианы.

1. Если объём выборки n – нечётный, то, разрешая уравнение (i – 0,5) / n = 0,5 относительно i, получаем номер элемента вариационного ряда, являющегося медианой, т.е.

.

2. Если объём выборки n – чётный, то выборочная медиана определяется путём линейной интерполяции элементов вариационного ряда с номерами и , имеющих порядки квантилей и соответственно. Результатом этой интерполяции будет среднее значение

Выборочные квантили и на уровнях 0,25 и 0,75 называют выборочными нижней и верней квартилями соответственно. Разность Δ между верней и нижней квартилями называется интерквартильным интервалом:

.

Интерквартильный интервал является характеристикой разброса выборочных значений и является, в некотором смысле, аналогом дисперсии.

Выборочные квантили ,…, на уровнях, кратных 0,1, называются выборочными децилями, а выборочные квантили ,…, на уровнях, кратных 0,01, – выборочными процентилями.

Выборочной модой выборки x1,…, xn с вариантами z1,…,zk называется вариант zi, , частота ni которого максимальна.

Выборочные характеристики двумерного случайного вектора

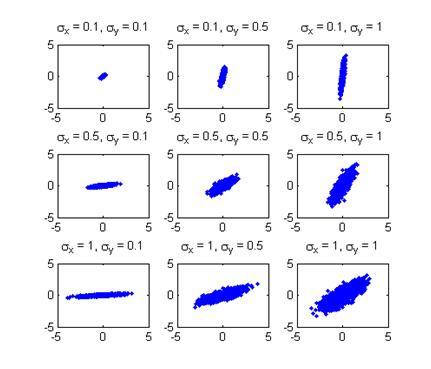

Выборочные характеристики можно ввести и для выборок из многомерных генеральных совокупностей. Пусть (x1, y1),…,(xn, yn) – выборка наблюдений двумерного случайного вектора (X, Y), имеющего распределение FXY(x, y). Пусть выборка содержит k различных пар наблюдений (вариантов) z1,…,zk, , причём вариант zi встречается с частотой ni, .

По аналогии с одномерным случаем введём случайный вектор дискретного типа , принимающий значения z1,…,zk с вероятностями, равными соответствующим относительным частотам, n1 / n,…, nk / n, т.е. , .

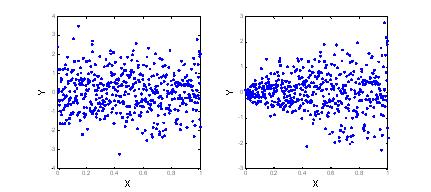

Распределение случайного вектора называется распределением двумерной выборки. Предварительное представление о распределении выборки можно получить, изображая элементы выборки точками на плоскости координат xOy. Это представление выборки называется диаграммой рассеяния (scatter plot).

Выборочными числовыми характеристиками двумерной выборки (x1, y1),…, (xn, yn) называются числовые характеристики случайного вектора . К таким характеристикам относятся, например, моменты случайного вектора.

Выборочный смешанный начальный момент порядка (q + r) равен:

где , а суммирование проводится по всем вариантам случайного вектора .

Учитывая, что случайный вектор принимает вариант (xi, yi) с вероятностью, равной относительной частоте ni этого наблюдения в выборке, и, представляя произведения как суммы ni одинаковых слагаемых , , формула (1) может быть записана в виде:

.

Аналогично, выборочный смешанный центральный момент порядка (q + r) определяется формулой:

.

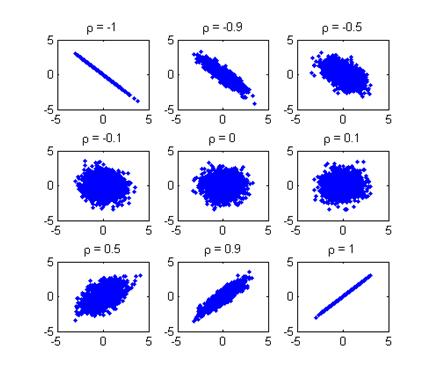

Наиболее часто используемой числовой характеристикой двумерного вектора является коэффициент корреляции. Напомним, что для случайного вектора дискретного типа (X, Y) коэффициент корреляции rXY определяется следующим образом:

где kXY – ковариационный момент, по определению .

Учитывая (2), определим выражение для выборочного коэффициента корреляции :

,

где – выборочный ковариационный момент:

.

Для выборочных ковариационного момента и коэффициента корреляции применимы все тождества, справедливые для ковариационного момента и коэффициента корреляции случайного вектора дискретного типа. В частности, полезное на практике соотношение между выборочным ковариационным моментом и выборочным смешанным начальным моментом второго порядка:

Это равенство следует читать как «выборочный ковариационный момент равен разности между средним произведением и произведением средних».

Двумерная выборка может быть представлена в виде корреляционной таблицы. Корреляционная таблица (табл. 1.4) является аналогом группированного статистического ряда для одномерной выборки.

Для построения корреляционной таблицы отрезок [x(1); x(n)], содержащий все наблюдения случайной величины X, разбивается на l непересекающихся интервалов [α0 = x(1); α1), [α1; α2),…, [αl-1; αl = x(n)], как правило, одинаковой ширины h1. Аналогично отрезок [y(1); y(n)], содержащий все наблюдения случайной величины Y, разбивается на m непересекающихся интервалов [β0 = β(1); β1), [β1; β2),…, [βm-1; βm = y(n)], как правило, одинаковой ширины h2. Правые границы всех интервалов, за исключением последнего, задаются открытыми, чтобы исключить попадание граничных точек в соседний интервал.

Процедуру группировки двумерных выборочных наблюдений можно выполнить непосредственно по диаграмме рассеяния, нанеся на неё сетку горизонтальных и вертикальных прямых, взятых с постоянными шагами h1 и h2 и рассчитав частоты nij попадания выборочных точек в каждый прямоугольник.

, , .

Таблица 1.4

Корреляционная таблица

[β0; β1) |

... |

[βj-1; βj) |

... |

[βm-1; βm] |

|

[α0; α1) |

n11 |

... |

n1j |

... |

n1l |

... |

... |

... |

... |

... |

... |

[αi-1; αi) |

ni1 |

... |

nij |

... |

nil |

... |

... |

... |

... |

... |

... |

[αl-1; αl] |

nl1 |

... |

nlj |

... |

nlm |

Очевидно, что сумма всех частот в корреляционной таблице равна объёму выборки .

Точечные оценки

Свойства точечных оценок

Пусть x1,...,xn – выборка наблюдений случайной величины X, имеющей распределение FX(x). При проведении ряда статистических исследований вид функции распределения наблюдаемой случайной величины зачастую предполагается известным (например, случайная величина имеет нормальное или биномиальное распределение). Неизвестными же являются параметры этого распределения.

Одной из задач математической статистики является оценка неизвестных параметров распределения наблюдаемой случайной величины X по выборке x1,..., xn её наблюдений.

Параметром θ∈Θ распределения FX(x) случайной величины X называется любая числовая характеристика этой случайной величины (математическое ожидание, дисперсия и т.п.) или любая константа, явно входящая в выражение для функции распределения FX(x).

В общем случае будем считать, что распределение FX(x) характеризуется вектором параметров .

Например, пусть масса деталей, изготавливаемых станком, в силу присутствия неточности работы станка является случайной величиной X, имеющей нормальное распределение, но его параметры и неизвестны. Требуется найти приближённое значение этих параметров по выборке наблюдений x1,..., xn масс n изготовленных станком деталей.

Напомним, что любая выборка наблюдений x1,...,xn является реализацией случайной выборки X1,...,Xn. Статистикой Z в математической статистике называется произвольная функция случайной выборки, не зависящая от неизвестных параметров распределения:

.

В связи с тем, что статистика Z является функцией случайных аргументов, Z является случайной величиной. Для каждой реализации x1,...,xn случайной выборки X1,...,Xn получим соответствующую ей реализацию z статистики Z:

,

называемую выборочным значением статистики Z.

Точечной оценкой неизвестного параметра θ∈Θ (или вектора параметров) распределения FX(x) называется произвольная статистика , построенная по случайной выборке X1,...,Xn из генеральной совокупности X и принимающая значения из множества Θ:

Точечная оценка является случайной величиной. Для выборки x1,..., xn может быть рассчитана реализация точечной оценки, или выборочное значение точечной оценки, неизвестного параметра θ∈Θ. Далее точечную оценку и её выборочное значение будем обозначать одинаково через , при необходимости дополнительно оговаривая, является ли случайной величиной или её реализацией.

В соответствии с определением (1) существует бесконечно много точечных оценок неизвестного параметра θ. Формально точечная оценка может не иметь ничего общего с интересующим нас параметром θ. Её полезность для получения практически приемлемых оценок вытекает из статистических свойств, которыми она обладает.

Основные свойства точечных оценок.

1. Состоятельность (Consistency)

Точечная оценка называется состоятельной оценкой параметра θ, если последовательность случайных величин сходится по вероятности к оцениваемому параметру θ при , т.е.

.

Иными словами, для состоятельной оценки вероятность её отклонения от оцениваемого параметра θ на любую малую величину e при увеличении объёма выборки стремится к нулю. Это свойство оценки является очень важным, ибо несостоятельная оценка практически бесполезна. Для несостоятельной оценки её значение, рассчитанное даже для выборки очень большого объёма, может существенно отличаться от значения параметра θ, а увеличение объёма выборки может не улучшать её качество.

Состоятельность оценки может быть проверена, используя достаточное условие состоятельности: если и при , то оценка является состоятельной.

Доказательство этого утверждения следует из второго неравенства Чебышева, согласно которому

.

Переходя к пределу при получаем

,

из чего следует состоятельность оценки .

2. Несмещённость (Bias)

Точечная оценка называется несмещённой оценкой параметра θ∈Θ, если её математическое ожидание равно оцениваемому параметру θ, т.е.

|

. |

Разность называется смещением точечной оценки .

Статистика называется несмещённой оценкой параметра θ, если условие (2) выполнено для любого фиксированного объёма выборки n.

Статистика называется асимптотически несмещённой оценкой параметра θ∈Θ, если числовая последовательность математических ожиданий сходится к оцениваемому параметру θ при , т.е.

.

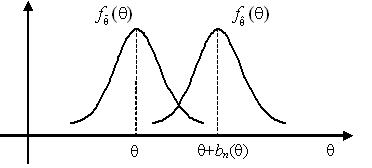

Несмещённость оценки означает, что реализации этой оценки, рассчитанные для различных реализаций случайной выборки X1,...,Xn объёма n, будут группироваться в среднем около оцениваемого параметра θ.

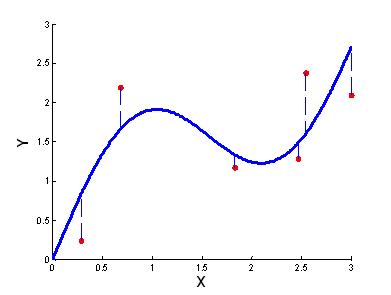

Реализации несмещённой точечной оценки группируются около оцениваемого параметра θ, а реализации смещённой оценки – около величины θ + bn(θ).

3. Эффективность (Efficiency)

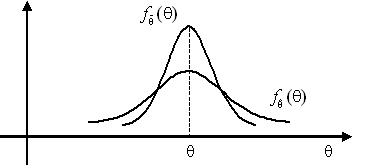

Для оценки параметра θ может быть предложено несколько несмещённых оценок. Вследствие несмещённости различные реализации этих оценок будут группироваться относительно их математического ожидания, равного θ, однако разброс этих значений может быть различным. Как известно, мерой разброса значений случайной величины относительно математического ожидания является её дисперсия.

Пусть и – две несмещённые оценки параметра q по выборке объёма n. Оценка называется более эффективной, чем оценка , если её дисперсия меньше, т.е.

Статистика называется более эффективной оценкой параметра θ∈Θ, чем статистика , если условие (3) выполнено для любого фиксированного объёма выборки n.

Если оценка более эффективна, чем оценка , то это означает, что реализации оценки , рассчитанные для различных реализаций случайной выборки X1,...,Xn объёма n, будут иметь меньший разброс около оцениваемого параметра θ, чем реализации менее эффективной оценки .

Оценка параметра θ, имеющая минимально возможную дисперсию среди всех оценок, называется эффективной оценкой параметра θ. В математической статистике наряду с термином «эффективная оценка» используют и другие: «несмещённая оценка с минимальной дисперсией», «оптимальная оценка».

Для того чтобы ответить на вопрос, является ли статистика эффективной оценкой параметра θ, используется неравенство Рао-Крамера (Calyampudi Radhakrishna Rao, Harald Cramer, 1945):

,

согласно которому любая оценка параметра θ ограничена снизу величиной при выполнении некоторых условий регулярности (выполнены практически для всех используемых на практике оценок), где In(θ) – количество информации по Фишеру о параметре θ, содержащееся в выборке объёма n.

Таким образом, критерием эффективности оценки является обращение для неё в равенство неравенства Рао-Крамера.

Эффективностью оценки параметра θ называется отношение

.

Согласно неравенству Рао-Крамера эффективность любой точечной оценки ограничена сверху единицей, а для эффективных оценок .

При выполнении условий регулярности каждый элемент независимой случайной выборки X1,...,Xn вносит равный вклад в информацию Фишера In(θ), т.е.

|

, |

где I(θ) – количество информации по Фишеру о параметре θ, содержащееся в одном выборочном наблюдении.

Величина информации по Фишеру зависит от вида распределения генеральной совокупности X. Так, выборки, полученные из генеральных совокупностей с разными распределениями (например, нормальным и биномиальным) будут содержать различное количество информации о неизвестных математическом ожидании или дисперсии.

Чем больше информации по Фишеру о параметре θ содержится в выборочных наблюдениях, тем меньший разброс имеют реализации эффективной оценки этого параметра, а следовательно, являются более точными.

Формально информация по Фишеру о параметре θ, содержащаяся в одном выборочном наблюдении из генеральной совокупности с функцией плотности распределения fX(x, θ), рассчитывается по формуле

|

, |

где функция

называется вкладом выборки.

В случае дискретной генеральной совокупности с распределением вероятностей P(x, θ), , вклад выборки определяется как

|

. |

Статистика является асимптотически эффективной оценкой параметра θ, если последовательность дисперсий сходится к величине, обратной информации Фишера при , т.е.

.

Методы получения точечных оценок

Точечной оценкой неизвестного параметра θ, вообще говоря, может являться любая статистика. Однако на практике интерес представляют лишь наиболее «качественные» оценки, для которых вероятность того, что при реализации случайной выборки они примут значение максимально близкое к неизвестному значению θ наибольшая. Такие оценки должны быть несмещёнными, состоятельными и эффективными. Возникает вопрос, как получить качественную оценку для произвольного параметра θ наблюдаемой случайной величины X?

1. Метод подстановки

Метод подстановки является наиболее простым методом получения точечных оценок. Метод состоит в том, что в качестве оценки неизвестного параметра θ выбирается соответствующая выборочная числовая характеристика:

.

Например, согласно методу подстановки оценкой математического ожидания будет выборочное среднее, а оценкой дисперсии – выборочная дисперсия.

Все оценки, рассчитанные по методу подстановки, являются состоятельными, однако их несмещённость и эффективность не гарантированы. Примером смещённой оценки, рассмотренной ранее, является выборочная дисперсия.

2. Метод моментов

Пусть x1,…,xn – выборка наблюдений случайной величины X, имеющей распределение FX(x, θ) с вектором неизвестных параметров . Предположим, что для этого распределения могут быть рассчитаны начальные и центральные моменты некоторых порядков r. Эти моменты являются функциями неизвестных параметров θ1,…,θk. С другой стороны, для выборки могут быть рассчитаны выборочные начальные и центральные моменты тех же порядков r.

Метод моментов состоит нахождении такого вектора параметров θ, при котором теоретические моменты равны выборочным моментам, т.е. в разрешении системы уравнений вида:

Число уравнений в системе (1) равно числу неизвестных параметров k. Для получения оценок по методу моментов, вообще говоря, могут быть выбраны любые моменты произвольных порядков, однако, как правило, на практике используют лишь моменты низших порядков.

Все оценки, рассчитанные по методу моментов, являются состоятельными, однако их несмещённость и эффективность, так же, как и в случае метода подстановки, не гарантированы.

Точечные оценки, полученные по методу моментов, называются ММ-оценками.

3. Метод максимального правдоподобия

Метод максимального правдоподобия (maximum likelihood estimation, MLE) является наиболее популярным методом оценивания неизвестных параметров распределений.

Пусть x1,…,xn – выборка наблюдений случайной величины X, имеющей распределение FX(x, θ) с вектором неизвестных параметров . Функцией правдоподобия выборки x1,…, xn из генеральной совокупности X называется совместная функция плотности распределения случайного вектора при условии, что его реализация :

.

Учитывая, что компоненты X1,…, Xn случайной выборки, реализациями которых являются выборочные значения x 1,…,xn, независимы, многомерная функция плотности есть произведение одномерных функций плотностей:

В (2) учтено, что все компоненты X1,…, Xn имеют одинаковое распределение, совпадающее с распределением генеральной совокупности X.

Функция правдоподобия выборки x1,…, xn является функцией только вектора неизвестных параметров θ.

Аналогично определяется функция правдоподобия для случая дискретной генеральной совокупности с распределением вероятностей P(x, θ), :

.

Метод максимального правдоподобия состоит в том, что в качестве оценки вектора неизвестных параметров принимается вектор , доставляющий максимум функции правдоподобия, т.е.

.

Иными словами, метод максимального правдоподобия состоит в отыскании такого вектора параметров , при котором данная реализация x1,…, xn случайной выборки X1,…,Xn была бы наиболее вероятной.

Запишем необходимое условие экстремума функции правдоподобия:

Это система k уравнений с k неизвестными θ1,…,θk, решая которую, получаем оценки неизвестных параметров распределения.

На практике бывает удобно вместо системы уравнений (3) составить систему уравнений

,

которая имеет те же решения. Функция называется логарифмической функцией правдоподобия.

Все оценки, рассчитанные по методу максимального правдоподобия, являются состоятельными и, по крайней мере, асимптотически несмещёнными и асимптотически эффективными. Если для неизвестного параметра существует эффективная оценка, то метод максимального правдоподобия даёт именно эту оценку.

Точечные оценки, полученные по методу максимального правдоподобия, называются МП-оценками.

Точечные оценки математического ожидания и дисперсии

1. Оценки математического ожидания

1) Оптимальной оценкой математического ожидания является выборочное среднее

.

Оценка является несмещённой, состоятельной, эффективной.

2) На практике нередко возникает необходимость быстрой оценки математического ожидания. Такой оценкой может быть

.

Оценка является состоятельной и, по крайней мере, асимптотически несмещённой и асимптотически эффективной.

3) В качестве оценки математического ожидания симметричного распределения может быть использована выборочная медиана

.

Можно показать, что при больших объёмах выборки распределение статистики аппроксимируется нормальным распределением . Таким образом, эффективность выборочной медианы как оценки математического ожидания равна

.

Оценка является состоятельной, несмещённой, но неэффективной.

4) Рассмотрим две выборки объёмов n1 и n2 из одной генеральной совокупности. Пусть и – выборочные средние. Тогда агрегированная оценка математического ожидания генеральной совокупности:

является несмещённой, состоятельной, эффективной.

2. Оценки дисперсии

1) Оптимальной оценкой дисперсии является исправленная выборочная дисперсия:

.

Оценка является несмещённой, состоятельной, эффективной.

2) Выборочная дисперсия

.

Оценка является асимптотически несмещённой, состоятельной, асимптотически эффективной.

3) На практике нередко возникает необходимость быстрой оценки дисперсии. Такой оценкой может быть

.

Оценка является грубой, для большинства распределений смещённой и неэффективной.

4) В случае если известно математическое ожидание m генеральной совокупности, оптимальной оценкой дисперсии является статистика:

.

Оценка является несмещённой, состоятельной, эффективной.

5) Рассмотрим две выборки объёмов n1 и n2 из одной генеральной совокупности. Пусть и – исправленные выборочные дисперсии. Тогда агрегированная оценка дисперсии генеральной совокупности

является несмещённой, состоятельной, эффективной.

Интервальные оценки

Понятие доверительного интервала

Точечная оценка неизвестного параметра θ является случайной величиной, определяемой как некоторая функция случайной выборки X1,…,Xn. Это означает, что для каждой новой реализации x1,…,xn этой выборки точечная оценка каждый раз будет иметь новое значение. Использование точечных оценок не даёт ответа на вопрос, насколько для данной выборки x1,…, xn рассчитанная реализация точечной оценки близка к значению оцениваемого параметра θ. Ответ на этот вопрос могут дать интервальные оценки. Интервальная оценка позволяет получить вероятностную характеристику точности оценивания неизвестного параметра θ.

Пусть X1,…,Xn – случайная выборка объёма n из генеральной совокупности X с функцией распределения FX(x; θ), зависящей от параметра θ, значение которого неизвестно. Доверительным интервалом для параметра θ называется интервал (θ1; θ2), содержащий (накрывающий) истинное значение θ с заданной вероятностью γ, т.е.

где и – некоторые статистики. Вероятность γ называется доверительной вероятностью, а вероятность – уровнем значимости. Доверительный интервал с доверительной вероятностью γ называют также γ-доверительным интервалом, или γ-доверительной интервальной оценкой параметра θ. Статистики θ1 и θ2 называются нижней и верхней границами доверительного интервала соответственно.

Доверительный интервал – это интервал со случайными границами θ1 и θ2. Для каждой новой реализации x1,…,xn случайной выборки X1,…,Xn эти случайные величины, а следовательно, и случайные величины θ1, θ2 будут принимать новые значения. Однако, согласно определению, для данной реализации x1,…,xn рассчитанная реализация доверительного интервала (θ1; θ2) накроет истинное значение неизвестного параметра θ с заданной вероятностью γ. Это означает, что доля реализаций случайной выборки X1,…,Xn, для которых доверительный интервал (θ1; θ2) накроет θ, в среднем равна доверительной вероятности γ.

Пример. Исследуется качество партии выпускаемых предприятием изделий. Пусть θ – доля бракованных изделий в партии, которую оценивают независимо друг от друга в N различных лабораториях по результатам обследования нескольких случайно выбранных деталей из партии. Иначе говоря, долю бракованных изделий в партии в каждой лаборатории оценивают по «своей» выборке деталей из партии, и в каждой лаборатории получают свои значения верхней и нижней границ γ-доверительного интервала.

Возможны случаи, когда γ-доверительный интервал не накрывает истинного значения θ. Если M – число таких случаев, то их доля будет стремиться к уровню значимости α при увеличении N, т.е. при .

Ширина доверительного интервала, характеризующая точность интервального оценивания, зависит от объёма выборки n и доверительной вероятности γ: при увеличении объёма выборки ширина доверительного интервала уменьшается. Причина этого состоит в том, что в выборке большего объёма содержится больше информации об оцениваемом параметре, что позволяет более точно определить область, в которой он находится. При увеличении доверительной вероятности предъявляется более «жёсткое» требование к вероятности нахождения неизвестного параметра внутри доверительного интервала, вследствие чего его ширина увеличивается.

Границы доверительного интервала θ1 и θ2 могут быть выбраны множеством способов. Единственное требование, предъявляемое к этим статистикам – это выполнение условия (1). Однако на практике, как правило, эти статистики выбирают, исходя из некоторых соображений симметрии, которые будут рассмотрены далее.

Иногда требуется оценить параметр θ только снизу или только сверху. При этом, если

,

то доверительный интервал (θ1; ∞) называется правосторонним, а статистика – односторонней нижней границей доверительного интервала.

Если же

,

то доверительный интервал (-∞; θ2) называется левосторонним, а статистика – односторонней верхней границей доверительного интервала.

Метод построения доверительных интервалов

Пусть X1,…,Xn – случайная выборка объёма n из генеральной совокупности X с функцией распределения FX(x; θ), зависящей от параметра θ, значение которого неизвестно. Наиболее простым и популярным методом построения доверительного интервала (θ1; θ2) для неизвестного параметра θ является метод, основанный на использовании так называемой центральной статистики.

Центральной статистикой случайной выборки X1,…,Xn называется любая статистика , зависящая от неизвестного параметра θ, удовлетворяющая следующим свойствам:

1. закон распределения FZ(z) статистики Z известен и не зависит от θ;

2. статистика Z непрерывна и строго монотонна по θ.

Из определения квантиля следует, что для любой случайной величины, в том числе, и для статистики справедливо равенство:

где и – квантили случайной величины Z на уровнях α/2 и (1–α/2) соответственно.

При построении односторонних доверительных интервалов рассматриваются другие равенства:

Задача нахождения доверительного интервала состоит в разрешении неравенства, стоящего под знаком вероятности в выражении (1) (или выражениях (2), (3)), относительно неизвестного параметра θ. В результате получим эквивалентное выражение:

,

из которого следует, что интервал является доверительным.

Таким образом, алгоритм построения доверительного интервала для неизвестного параметра θ на основе случайной выборки X1,…,Xn состоит в следующем.

1. Выбор центральной статистики и определение её закона распределения FZ(z). Знание закона распределения необходимо для расчёта квантилей и (или zα и z1-α).

2. Разрешение неравенства под знаком вероятности в выражении (1) (или выражениях (2), (3)) относительно θ.

Очевидно, что для случайной выборки X1,…, Xn в общем случае может быть построено бесконечно много центральных статистик Z. Возникает вопрос, какую центральную статистику выбрать, чтобы полученный с её помощью доверительный интервал был бы наиболее узким, а следовательно, наиболее точным, при фиксированной доверительной вероятности ?

Как правило, центральные статистики связывают с некоторой точечной оценкой неизвестного параметра θ. Чем меньше дисперсия точечной оценки , тем меньшей дисперсией будет обладать и центральная статистика Z, построенная на основе . А для случайной величины с меньшей дисперсией интервал будет ýже при прочих равных условиях. Учитывая монотонность зависимости центральной статистики Z от параметра θ, заключаем, что чем ýже интервал , тем ýже доверительный интервал (θ1; θ2). Таким образом, из вышесказанного следует, что центральную статистику целесообразно выбирать связанной с эффективной оценкой неизвестного параметра θ.

Законы распределения некоторых статистик нормальной выборки

Пусть X1,…,Xn – случайная выборка объёма n из нормально распределённой генеральной совокупности N(m, σ). Для вывода выражений для доверительных интервалов найдём законы распределения некоторых статистик, которые могут быть выбраны как центральные.

1. Статистика (среднее арифметическое).

В силу композиционной устойчивости нормального распределения статистика имеет распределение .

2. Статистика (стандартизованное среднее арифметическое при известной дисперсии).

Статистика имеет распределение .

3. Статистика (оценка дисперсии при известном математическом ожидании).

Для вывода закона распределения домножим и разделим каждое слагаемое на σ2:

,

где случайные величины Ui, , независимы и имеют стандартизованное нормальное распределение N(0, 1). По определению закона распределения хи-квадрат, случайная величина . Далее будем записывать, что статистика .

4. Статистика (оценка дисперсии при неизвестном математическом ожидании).

Теорема Фишера. Пусть X1,…, Xn – независимые случайные величины, имеющие нормальное распределение N(m, σ). Тогда случайные величины и S2 независимы, и случайная величина .

5. Статистика (стандартизованное среднее арифметическое при неизвестной дисперсии).

Применяя выражение для статистики U, запишем

.

По определению закона распределения Стьюдента статистика .

Запишем теперь законы распределения некоторых статистик, связанных с двумя случайными выборками. Пусть и – случайные выборки объёмов n1 и n2 из нормально распределённых генеральных совокупностей N(m1, σ1) и N(m2, σ2) соответственно.

6. Статистика (агрегированное среднее).

Средние арифметические выборок имеют нормальные распределения и . В связи с композиционной устойчивостью нормального распределения статистика также будет иметь нормальное распределение. Применяя свойства операторов математического ожидания и дисперсии, находим его параметры:

,

.

7. Статистика (стандартизованное агрегированное среднее арифметическое при известной дисперсии).

Статистика имеет распределение .

8. Статистика (агрегированная оценка дисперсии при известном математическом ожидании).

Если , то статистика имеет распределение .

9. Статистика (агрегированная оценка дисперсии при неизвестном математическом ожидании).

Если , то статистика имеет распределение .

10. Статистика (разность средних при известных дисперсиях).

В связи с композиционной устойчивостью нормального распределения статистика Δ будет иметь нормальное распределение. Применяя свойства операторов математического ожидания и дисперсии, находим его параметры:

,

.

11. Статистика (стандартизованная разность средних при известных дисперсиях).

Статистика имеет распределение .

В частном случае, если , то

.

12. Статистика (стандартизованная разность средних при неизвестных дисперсиях).

Если , то

.

По определению закона распределения Стьюдента статистика .

13. Статистика (стандартизованное отношение дисперсий при известном математическом ожидании).

Применяя выражение для статистики , запишем:

.

По определению закона распределения Фишера статистика .

14. Статистика (стандартизованное отношение дисперсий при не известном математическом ожидании).

Применяя выражение для статистики (см. п.4), запишем:

.

По определению закона распределения Фишера статистика .

Построение интервальных оценок параметров нормального распределения

Пусть X1,…,Xn – случайная выборка объёма n из нормально распределённой генеральной совокупности N(m, σ). Рассмотрим варианты построения доверительных интервалов для математического ожидания m и дисперсии σ2.

1. Доверительный интервал для математического ожидания m при известной дисперсии σ2.

В качестве центральной статистики выберем стандартизованное среднее . При таком выборе центральной статистики доверительный интервал для математического ожидания на уровне значимости α имеет вид:

.

2. Доверительный интервал для математического ожидания m при неизвестной дисперсии σ2.

В качестве центральной статистики выберем стандартизованное среднее . Запишем тождество (1*) для статистики T:

,

где и – квантили распределения Стьюдента с n–1 степенями свободы на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно m и учитывая симметричность распределения Стьюдента, получим:

,

откуда следует, что интервал

является доверительным для m на уровне значимости α.

3. Доверительный интервал для дисперсии σ2 при известном математическом ожидании m.

В качестве центральной статистики выберем статистику . Запишем тождество (1*):

,

где и – квантили распределения хи-квадрат с n степенями свободы на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно σ2, получим:

,

откуда следует, что интервал является доверительным для σ2 на уровне значимости α.

4. Доверительный интервал для дисперсии σ2 при неизвестном математическом ожидании m.

В качестве центральной статистики выберем статистику . Запишем тождество (1*):

,

где и – квантили распределения хи-квадрат с n-1 степенями свободы на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно σ2, получим:

,

откуда следует, что интервал является доверительным для σ2 на уровне значимости α.

Рассмотрим теперь варианты построения доверительных интервалов, связанных с двумя выборками. Пусть и – случайные выборки объёмов n1 и n2 из нормально распределённых генеральных совокупностей N(m1, σ1) и N(m2, σ2) соответственно.

5. Доверительный интервал для разности математических ожиданий m1 – m2 при известных дисперсиях и .

В качестве центральной статистики выберем стандартизованную разность средних при известных дисперсиях:

.

Запишем тождество (1*):

,

где и – квантили стандартизованного нормального распределения на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно m1 – m2 и учитывая симметричность нормального распределения, получим:

,

откуда следует, что интервал

является доверительным для m1 – m2 на уровне значимости α.

6. Доверительный интервал для разности математических ожиданий m1 – m2 при неизвестных равных дисперсиях .

В качестве центральной статистики выберем стандартизованную разность средних при неизвестных равных дисперсиях

.

Запишем тождество (1*):

,

где и – квантили распределения Стьюдента с n1+n2–2 степенями свободы на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно m1 – m2 и учитывая симметричность распределения Стьюдента, получим:

,

откуда следует, что интервал

;

является доверительным для m1 – m2 на уровне значимости α.

7. Доверительный интервал для отношения дисперсий при известных математических ожиданиях m1 и m2.

В качестве центральной статистики выберем статистику .

Запишем тождество (1*):

,

где и – квантили распределения Фишера с n1 и n2 степенями свободы в числителе и в знаменателе на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно и учитывая, что , получим:

,

откуда следует, что интервал

является доверительным для на уровне значимости α.

8. Доверительный интервал для отношения дисперсий при неизвестных математических ожиданиях m1 и m2.

В качестве центральной статистики выберем статистику .

Запишем тождество (1*):

,

где и – квантили распределения Фишера с n1–1 и n2–1 степенями свободы в числителе и в знаменателе на уровнях α/2 и 1–α/2 соответственно.

Разрешая неравенство под знаком вероятности относительно и учитывая, что , получим:

,

откуда следует, что интервал

является доверительным для на уровне значимости α.

Интервальная оценка вероятности «успеха» в схеме Бернулли

Пусть проводится серия из n испытаний по схеме Бернулли, и Xi, , – исход i-го испытания (Xi = 1, если «успех», и Xi = 0, если «отказ»). По данным случайной выборки X1,…,Xn построим доверительный интервал для вероятности p успеха в каждом отдельном испытании.

Рассмотрим число «успехов» в серии из n испытаний, т.е. введём случайную величину

,

которая имеет биномиальное распределение . Математическое ожидание и дисперсия .

В соответствии с предельной теоремой Муавра-Лапласа при больших объёмах n случайной выборки статистика K имеет закон распределения, близкий к нормальному: .

Для построения доверительного интервала введём центральную статистику:

.

Статистика представляет собой стандартизованное число «успехов» в серии из n испытаний и при больших n имеет распределение, близкое к N(0, 1).

Запишем тождество (1*) для статистики U:

,

где и – квантили стандартизованного нормального распределения на уровнях α/2 и 1–α/2 соответственно. Преобразуя неравенство под знаком вероятности, запишем:

.

Это выражение ещё не даёт интервальной оценки параметра p, так как левая и правая части неравенства под знаком вероятности содержат этот параметр. На практике в указанные части неравенства подставляют вместо неизвестного точного значения p его эффективную оценку . В результате получают следующий интервал для вероятности p:

,

являющийся доверительным на уровне значимости α.

Указанные границы доверительного интервала являются приближёнными и могут использоваться лишь при достаточно больших объёмах наблюдений n.

Пусть теперь проводятся две серии испытаний по схеме Бернулли, и требуется построить доверительный интервал для разности вероятностей «успехов» p1 и p2 в этих сериях. Случайные величины и , означающие число «успехов» в первой и второй сериях соответственно, имеют биномиальные распределения , , где n1 и n2 – число испытаний в сериях.

В соответствии с предельной теоремой Муавра-Лапласа при больших объёмах n1 и n2 случайных выборок статистики K1 и K2 имеют законы распределения, близкие к нормальному: , . Перейдём от числа «успехов» K1 и K2 к относительным частотам «успехов» H1 и H2:

,

.

В силу композиционной устойчивости нормального распределения, разность относительных частот также будет иметь нормальное распределение:

.

Для построения доверительного интервала введём центральную статистику:

.

Статистика представляет собой стандартизованную разность числа «успехов» в двух сериях испытаний и при больших n1 и n2 имеет распределение, близкое к N(0, 1).

Запишем тождество (1*) для статистики U:

,

где и – квантили стандартизованного нормального распределения на уровнях α/2 и 1–α/2 соответственно. Преобразуя неравенство под знаком вероятности, запишем:

.

Это выражение ещё не даёт интервальной оценки разности вероятностей p1 – p2, так как левая и правая части неравенства под знаком вероятности содержат эти параметры. На практике в указанные части неравенства подставляют вместо неизвестных точных значений p1 и p2 их эффективные оценки и . В результате получают следующий интервал для разности вероятностей p1 – p 2:

,

являющийся доверительным на уровне значимости α.

Указанные границы доверительного интервала являются приближёнными и могут использоваться лишь при достаточно больших объёмах наблюдений n1 и n2.

Проверка статистических гипотез

Основные понятия и определения

В практических задачах часто требуется проверить то или иное предположение относительно каких-нибудь свойств закона распределения наблюдаемой случайной величины X. Для проверки этого предположения исследователь проводит эксперимент, в результате которого получает реализацию x1,...,xn случайной выборки X1,...,Xn из генеральной совокупности X. По этим данным ему нужно дать ответ на вопрос: согласуется ли его гипотеза с результатами эксперимента или нет? Другими словами, исследователю нужно решить, можно ли принять выдвинутую гипотезу или её нужно отклонить как противоречащую результатам эксперимента.

Любое предположение относительно параметров или закона распределения наблюдаемой случайной величины (или нескольких величин) называется статистической гипотезой. Проверяемую статистическую гипотезу также называют основной, или нулевой, статистической гипотезой и, как правило, обозначают H0.

Наряду с проверяемой статистической гипотезой H0 выдвигают также конкурирующую гипотезу, противоречащую H0. Конкурирующая гипотеза называется альтернативной и, как правило, обозначается H1 или H’. Если в результате статистического анализа делается вывод, что основная гипотеза H0 должна быть отвергнута, то решение принимается в пользу альтернативной гипотезы H’. В простейшем случае альтернативная гипотеза – это отрицание основной гипотезы.

Статистическая гипотеза H0 называется простой, если она однозначно определяет параметр или распределение наблюдаемой случайной величины X. В противном случае гипотеза H0 называется сложной.

Если статистическая гипотеза H0 представляет собой утверждение о некотором параметре q известного распределения случайной величины X, то гипотеза называется параметрической. В противном случае гипотеза называется непараметрической.

Статистическое решение, т.е. решение о принятии или отклонении основной гипотезы H0, проводится в соответствии с некоторым критерием.

Статистическим критерием, или решающим правилом, при проверке статистической гипотезы H0 называется правило, в соответствии с которым гипотеза H0 принимается или отвергается.

Статистическая гипотеза – это всегда утверждение о свойствах наблюдаемой генеральной совокупности, а задача проверки статистической гипотезы состоит в проверке соответствия результатов эксперимента x1,...,xn выдвинутой гипотезе. Иными словами, задача проверки статистической гипотезы состоит в ответе на вопрос: могло ли случиться так, что выборка x1,..., xn была получена из генеральной совокупности с указанными в гипотезе свойствами?

Как правило, статистический критерий связывают с некоторой статистикой Z, являющейся функцией случайной выборки X1,...,Xn. Эта статистика служит мерой, насколько наблюдаемые выборочные значения могли быть получены из генеральной совокупности с указанными в основной гипотезе свойствами. Вопрос о том, какую статистику Z следует взять для проверки той или иной статистической гипотезы, не имеет однозначного ответа. Это может быть любая статистика, удовлетворяющая следующим требованиям:

1) закон распределения FZ(z | H0) при условии истинности основной гипотезы H0 должен быть известен;

2) закон распределения должен быть чувствителен к факту справедливости основной или альтернативной гипотезы, т.е. законы распределения FZ(z | H0) и FZ(z | H’) должны существенно различаться.

Для реализации x1,...,xn случайной выборки X1,...,Xn, статистика Z примет реализацию z. Предположим, что гипотеза H0 верна. В связи с тем, что закон распределения статистики Z при условии истинности основной гипотезы H0 известен, то возможно рассчитать вероятность её попадания в некоторую окрестность точки z. Если эта вероятность высока, это означает, что ничто не противоречит предположению об истинности гипотезы H0. Если же эта вероятность мала или близка к нулю, то это может означать один из двух вариантов:

1) в условиях основной гипотезы H0 произошло практически невозможное событие;

2) статистика Z на самом деле имеет некоторый другой закон распределения, отличный от FZ(z | H0), при котором вероятность её попадания в окрестность точки z много больше нуля. Это означает, что предположение об истинности гипотезы H0 сделано неверно.

Статистика , на основе реализации которой выдвигается статистическое решение, называется статистикой критерия (test statistics). Реализация статистики критерия , рассчитанная для выборки x1,...,xn, называется выборочным значением статистики критерия.

Проверка статистических гипотез основывается на принципе, в соответствии с которым маловероятные события относительно статистики критерия Z считаются невозможными. В соответствии с этим принципом, если вероятность попадания статистики критерия Z в окрестность рассчитанного выборочного значения z мала, то должен выбираться вариант 2), т.е. основная гипотеза H0 отклоняется.

Область Ω0 наиболее вероятных значений статистики критерия Z, при попадании выборочных значений z в которую основная гипотеза H0 принимается, называется областью допустимых значений статистики критерия Z.

Область Ω’ маловероятных значений статистики критерия Z, при попадании выборочных значений z которую основная гипотеза H0 отклоняется, называется критической областью значений статистики критерия Z. Множество должно являться множеством всех возможных значений статистики критерия Z.

Из определений области допустимых значений и критической области следует статистический критерий проверки гипотезы H0: если выборочное значение статистики критерия , то основная гипотеза H0 принимается, если выборочное значение статистики критерия , то основная гипотеза H0 отвергается.

Пусть для выборки x1,...,xn статистика критерия Z приняла выборочное значение z, лежащее в критической области Ω’, т.е. вероятность попадания статистики критерия Z в окрестность которой мала. В соответствии со статистическим критерием основная гипотеза H0 должна быть отвергнута. Однако событие , хоть и с малой вероятностью, но всё же могло произойти в условиях основной гипотезы H0. Если это так, то статистическое решение об отклонении гипотезы H0 будет ошибочным.

С другой стороны, если для выборки x1,...,xn статистика критерия Z приняла выборочное значение z, лежащее в области допустимых значений Ω0, это могло случиться как в условиях основной гипотезы H0 (с высокой вероятностью), так и, возможно, в условиях альтернативной гипотезы H’ (с низкой вероятностью). В соответствии со статистическим критерием основная гипотеза H0 принимается. Если же событие на самом деле произошло в условиях альтернативной гипотезы H’, то статистическое решение о принятии гипотезы H0 также будет ошибочным. В обоих случаях говорят об ошибках принятия статистического решения.

Ошибкой 1-го рода при принятии статистического решения называется событие, состоящее в том, что основная гипотеза H0 отвергается, в то время как она верна.

Ошибкой 2-го рода при принятии статистического решения называется событие, состоящее в том, что основная гипотеза H0 принимается, в то время как верна альтернативная гипотеза H’.

Уровнем значимости α при проверке статистической гипотезы называется вероятность ошибки первого рода:

.

Вероятность β ошибки второго рода:

.

Ясно, что с уменьшением вероятности ошибки первого рода возрастает вероятность ошибки второго рода и наоборот. Это означает, что при выборе критической области и области допустимых значений статистики критерия должен достигаться определённый компромисс.

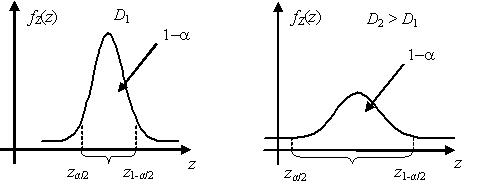

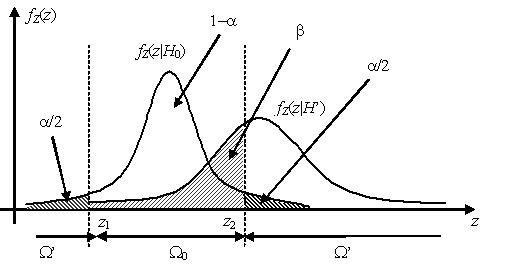

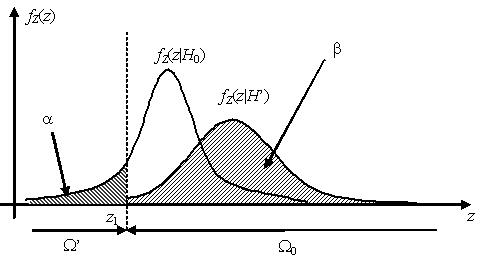

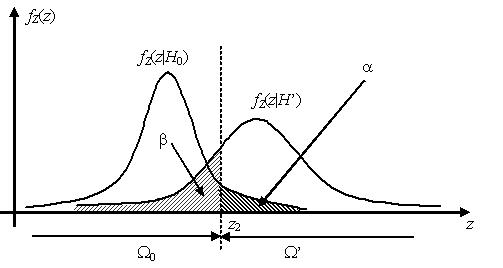

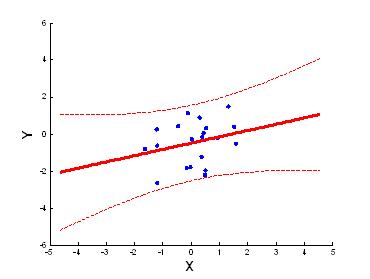

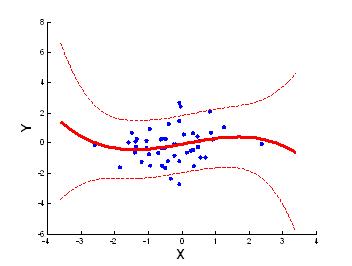

Проиллюстрируем сказанное на примере. Пусть основная и альтернативная гипотезы H0 и H’ являются простыми. Пусть статистики критерия Z при условии истинности основной гипотезы H0 имеет нормальное распределение , а при условии истинности H’ – распределение .

У качестве критической области Ω’ выбраны хвосты распределения , площадь каждого из которых равна α/2. Вероятность попадания статистики критерия Z, имеющей распределение , в критическую область, таким образом, равна вероятности ошибки первого рода α. Вероятность ошибки второго рода β равна площади под графиком функции плотности распределения внутри области допустимых значений Ω0. Из графиков видно, что уменьшая ширину области допустимых значений, площадь a будет увеличиваться, в то время как площадь β – уменьшаться, и наоборот.

Точки на оси значений статистики критерия z, разделяющие область допустимых значений Ω0 и критическую область Ω’, называются критическими точками. На рисунке выше это точки z1 и z2, являющиеся квантилями распределения на уровнях α/2 и 1 – α/2 соответственно.

В случае если основная и альтернативная гипотезы H0 и H’ являются простыми, величина μ = 1 – β называется мощностью критерия.

Очевидно, что при заданном значении вероятности ошибки первого рода a выбор критической области Ω’ может быть сделан неоднозначно. Единственное требование, предъявляемое к критической области, состоит в том, что площадь под графиком известного распределения статистики критерия в критической области должна быть равна α. Однако соответствующие различным критическим областям критерии будут иметь, вообще говоря, различные вероятности β ошибок второго рода.

Наилучшей критической областью (НКО) называют критическую область, которая при заданном уровне значимости a обеспечивает минимальную вероятность β ошибки второго рода. Критерий, использующий наилучшую критическую область, имеет максимальную мощность.

Если альтернативная гипотеза является сложной, т.е. не определяет однозначно функцию распределения FX(x) генеральной совокупности X, а следовательно, и функцию распределения статистики критерия , а определяет её с точностью до значения некоторого параметра θ, то вводят функцию мощности критерия μ(θ) как функцию параметра θ. Значение функции мощности критерия μ(θ) в точке θ определяется как

,

где β(θ) – вероятность ошибки второго рода при условии, что неизвестный параметр принял значение θ, θ∈Θ, где Θ – область возможных значений параметра θ.

Функция мощности имеет важное значение в задачах, связанных с оценкой необходимого объёма выборки для обеспечения требуемой вероятности ошибки второго рода принятия статистического решения при заданной вероятности ошибки первого рода.

Алгоритм проверки статистических гипотез

Далее будем рассматривать лишь случай простой основной статистической гипотезы. Алгоритм проверки любой простой гипотезы включает следующие этапы.

1) Сформулировать проверяемую гипотезу H0 и альтернативную гипотезу H’. Гипотезы формулируются, исходя из условия задачи или особенностей рассматриваемой проблемной области.

2) Выбрать уровень значимости α, на котором будет сделано статистическое решение. Уровень значимости выбирается исследователем как допустимая вероятность ошибки первого рода при принятии статистического решения. Обычно, уровень значимости выбирается небольшим, например, α = 0,1 или α = 0,01, однако, следует помнить, что выбор слишком малого уровня значимости приведёт к увеличению вероятности ошибки второго рода при принятии статистического решения.

3) Выбрать статистику критерия Z для проверки гипотезы H0. Для большинства встречающихся на практике статистических гипотез H0 выражение для статистики критерия Z, обеспечивающей минимальное или близкое к минимальному значение вероятности ошибки второго рода при фиксированном уровне значимости, известно. От исследователя, как правило, не требуется придумывать оригинальное выражение для используемой статистики критерия.

4) Найти закон распределения выбранной статистики критерия Z при условии истинности основной гипотезы H0. Законы распределения большинства используемых на практике статистик критерия также известны.

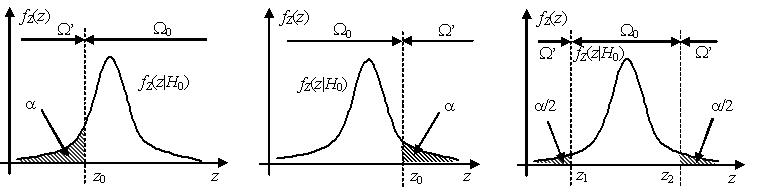

5) Построить область допустимых значений Ω0 и критическую область Ω’. Критическая область Ω’ зависит от вида статистики критерия Z, альтернативной гипотезы H’ и уровня значимости α.

Простая основная параметрическая гипотеза имеет вид , где θ – неизвестный параметр генеральной совокупности, θ0 – некоторая константа из области возможных значений параметра θ. Для такой основной гипотезы возможны следующие варианты формулировок альтернативных гипотез:

а) ;

б) ;

в) .

Как правило, оптимальная критическая область – это область маловероятных значений статистики критерия в хвостах распределения. Если критическая область расположена в левом хвосте распределения , то такая критическая область называется левосторонней, если в правом хвосте – то правосторонней, если в обоих хвостах – то двусторонней. В случае двусторонней критической области площади каждого из хвостов, как правило, выбираются равными.

Уровень значимости α определяет ширину критической области.

6) Вычислить выборочное значение статистики критерия z на основе имеющихся выборочных наблюдений из генеральной совокупности.

7) Принять статистическое решение, используя решающее правило: если выборочное значение статистики критерия , то основная гипотеза H0 принимается, если выборочное значение статистики критерия , то основная гипотеза H0 отвергается в пользу альтернативной гипотезы H’.

Иногда при использовании статистических пакетов для проверки гипотез процедура статистического анализа не возвращает в явном виде выборочное значение z статистики критерия Z. В этом случае статистическое решение принимается на основе так называемого значения p-value.

Если альтернативная гипотеза имеет вид , то значение p-value – это площадь под графиком функции плотности распределения статистики критерия, расположенная левее / правее выборочного значения статистики критерия z:

$H':\theta

Иными словами, p-value – это вероятность того, что статистика критерия Z примет более «экстремальные» значения в левом / правом хвосте критической области, чем рассчитанное по выборке выборочное значение z.

Если альтернативная гипотеза имеет вид , то p-value рассчитывается по следующей формуле:

.

В этом случае p-value – это вероятность того, что статистика критерия Z примет более «экстремальные» значения, чем z, в любом из хвостов двусторонней критической области.

Если значение p-value мало, это свидетельствует о том, что выборочное значение статистики критерия z уже приняло довольно «экстремальное» значение, что может говорить о противоречии выборочных данных основной гипотезе. Если значение p‑value велико, то оснований отвергать основную гипотезу нет.

При использовании значения p-value критерий проверки статистической гипотезы формулируется следующим образом: если значение p-value больше уровня значимости a, то основная гипотеза H0 принимается, если значение p‑value меньше уровня значимости a, то основная гипотеза H0 отвергается.

Если основная гипотеза H0 отвергается, то делается вывод, что выборочные наблюдения противоречат основной гипотезе, если же H0 принимается, то выборочные данные могли быть получены из генеральной совокупности со свойствами, указанными в H0, что, впрочем, не означает, что генеральная совокупность в самом деле имеет эти свойства.

Проверка гипотез о параметрах нормально распределённой генеральной совокупности

Пусть x1,…,xn – выборка наблюдений случайной величины X, имеющей нормальное распределение N(m, σ). Ниже приводятся наилучшие по мощности статистики критерия для различных вариантов гипотез относительно параметров m и s. Как правило, эти статистики связаны с эффективными оценками параметров, относительно которых выдвигаются гипотезы.

1) Гипотеза о значении математического ожидания при известной дисперсии (one-sampled z-test).

.

В качестве статистики критерия используется статистика

|

. |

При условии истинности H0 случайная величина

,

следовательно, .

2) Гипотеза о значении математического ожидания при неизвестной дисперсии (one-sample t-test).

В связи с тем, что σ не известно, статистику (1) здесь использовать нельзя. Вместо σ в (1) подставляется оценка S среднеквадратичного отклонения:

,

при этом в условиях истинности гипотезы H0 статистика Z будет иметь распределение Стьюдента с n–1 степенью свободы.

3) Гипотеза о значении дисперсии при известном математическом ожидании (chi-squared test).

.

Эффективной оценкой дисперсии при известном математическом ожидании является статистика . В качестве статистики критерия выберем статистику

.

Очевидно, что при условии истинности H0 статистика

.

4) Гипотеза о значении дисперсии при неизвестном математическом ожидании (chi-squared test).

.

Эффективной оценкой дисперсии при неизвестном математическом ожидании является статистика . В качестве статистики критерия выберем статистику

.

Очевидно, что при условии истинности H0 статистика

.

Запишем теперь статистики критерия для гипотез, связанных с параметрами двух генеральных совокупностей. Пусть и – выборки объёмов n1 и n2 из нормально распределённых генеральных совокупностей N(m1, σ1) и N(m2, σ2) соответственно.

5) Гипотеза о равенстве математических ожиданий при известных дисперсиях (two-sample z-test).

.

Статистики , .

Несложно показать, что при условии истинности H0 статистика

имеет стандартизованное нормальное распределение N(0; 1).

6) Гипотеза о равенстве дисперсий при известных математических ожиданиях (two-sample F-test).

.

В качестве статистики критерия используется отношение оценок дисперсий при известных математических ожиданиях

,

которое при условии истинности H0 распределено по закону Фишера .

7) Гипотеза о равенстве дисперсий при неизвестных математических ожиданиях (two-sample F-test).

.

В качестве статистики критерия используется отношение оценок дисперсий при неизвестных математических ожиданиях

,

которое при условии истинности H0 распределено по закону Фишера .

8) Гипотеза о равенстве математических ожиданий при неизвестных дисперсиях (two-sample unpooled t-test).

.

а) Дисперсии генеральных совокупностей равны (это может быть известно априорно, исходя из условия задачи, или в случае, если гипотеза при неизвестных математических ожиданиях принимается).

Объединённая оценка дисперсии σ2 по двум выборкам имеет вид:

.

При условии истинности H0 статистика S2 имеет распределение

.

Несложно показать, что статистика

при условии истинности H0 имеет распределение Стьюдента с n1+n2–2 степенями свободы.

б) Оснований считать, что дисперсии генеральных совокупностей равны, нет (Welch’s t-test).

Для каждой из дисперсий вычисляются свои оценки и . Статистика критерия имеет вид:

.

Показано, что при условии истинности H0 статистика Z имеет распределение Стьюдента с числом степеней свободы, равным целой части от величины 1 / k, где

.

Основные статистики критерия при проверке статистических гипотез о параметрах нормально распределённой генеральной совокупности и их законы распределения приведены в табл. 4.1.

Таблица 4.1

Статистики критерия при проверке статистических гипотез о параметрах нормально распределённой генеральной совокупности

Основная гипотеза, H0 |

Мат. ожидание |

Дисперсия |

Статистика критерия, Z |

Закон распределения, |

не изв. |

изв. |

|||

не изв. |

не изв. |

|||

изв. |

не изв. |

|||

не изв. |

не изв. |

|||

не изв. |

изв. |

|||

не изв. |

не изв., равные |

|

||

изв. |

не изв. |

|||

не изв. |

не изв. |

Все приведённые выше выражения для статистик критерия и их законов распределения справедливы, если случайная выборка X1,…, Xn (или выборки и ) получены из нормально распределённой генеральной совокупности. Однако поскольку все статистики основаны на оценках и S2, представляющих собой суммы случайных величин, то согласно центральной предельной теоремы теории вероятностей распределение этих статистик при больших объёмах выборок будет близко нормальному, даже если распределение каждого слагаемого отлично от нормального. В то же время, если генеральная совокупность распределена нормально, то статистика S2 имеет распределение хи-квадрат, которое при больших объёмах выборки также может быть аппроксимировано нормальным распределением. Это означает, что законы распределения статистик критерия остаются справедливыми при больших объёмах выборки в случае распределения генеральной совокупности, отличного от нормального.

В некоторых случаях для проверки параметрических статистических гипотез может быть использован метод доверительных интервалов. Пусть основная гипотеза , альтернативная гипотеза . Если для неизвестного параметра θ может быть построен доверительный интервал (θ1; θ2), то проверка статистической гипотезы H0 сводится к проверке попадания значения θ0 в доверительный интервал (θ1; θ2). Критерий проверки гипотез при использовании метода доверительных интервалов состоит в следующем: если θ0 ∈ (θ1; θ2), то основная гипотеза H0 должна приниматься, в противном случае – отклоняться. Если альтернативная гипотеза H’ имеет вид или , то строится соответствующий односторонний доверительный интервал (–∞; θ2) или (θ1; +∞).